过程记录

12月21日(周三)

下午的时候有些犯困,当时以为是前一天没有睡好。现在回想起来这时候可能已经感染新冠了。

12月22日(周四)

早上感觉喉咙有些痒。上班路上听广播里说喉咙痒是新冠的前兆,这时已经隐隐的有不好的预感了。下午开始零星的咳嗽,不好的预感加重,于是提前下班回家。到家后全程佩戴口罩。

由于除了喉咙有点痒以外没有其他不适,当时还认为不一定是新冠。

晚上睡觉后开始头痛外加持续的咳嗽,痛的一晚没有睡着。

12月23日(周五)

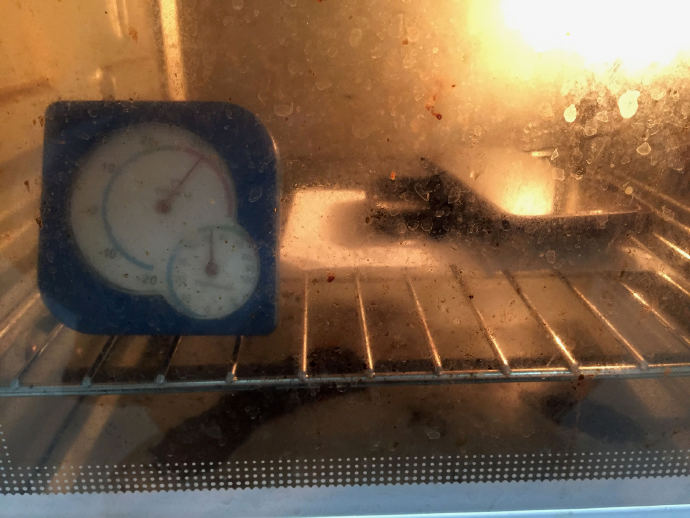

起床后体温为38.6度,持续一天都在这个温度。在床上躺了一天。由于头痛,只能干躺着,根本睡不早。抗原阳性。

早上吃了一片面包,中午一碗苗条,晚上一个苹果外加葡萄糖水。不敢多吃东西,感觉吃多了就要吐了。

由于头痛外加一直咳嗽,根本睡不着,一直没有休息好。睡前吃了一片布诺芬。晚上虽然还是一只醒,不过已经可以正常睡一段时间了。

12月24日(周六)

早上醒来后感觉好多了,体温降到了37.9,整个人舒服不少。一整天体温稳定在37.x。

出现嗅觉丧失情况。喷了很多酒精依旧闻不到酒精味。

晚上睡前鼻塞严重,不过难受程度比前两天低多了,勉强可以正常睡眠。

12月25日(周日)

早上醒来后,体温已经恢复正常,鼻塞也好了。全天除了咳嗽和流涕外没有其他不适。

嗅觉依旧未恢复。

睡前再度鼻塞。

12月26日(周一)

以外发现味觉减退的厉害。

疫苗情况

第一针和第二针疫苗针2021年7月,第三针疫苗针2022年11月(一个月前),都是科兴。理论上这段时间是疫苗保护效果最好的。

可能的感染来源

周一的时候,公司一下倒了好几个。身边的人也都陆续感染,因此本周大家都很自觉的佩戴了口罩。由于感染人数众多,公交车上一般还比较空。周二下班的时候由于公交车班次缩减的厉害(大量公交车师傅被感染了),回去的那趟公交车非常拥挤。感觉在这班公交车上被感染的概率比较大。